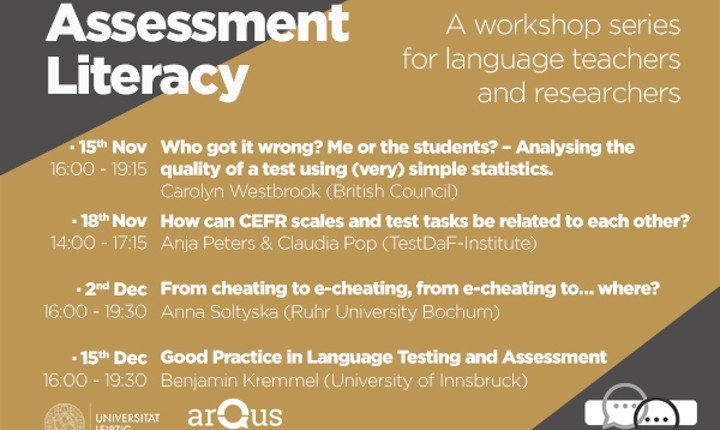

Arqus - Une série d'ateliers pour les professeurs de langues et les chercheur

Dans le cadre de la série sur les compétences linguistiques et interculturelles pour le personnel des universités partenaires, l'Université de Leipzig organise quatre ateliers thématiques distincts au cours des mois de novembre et décembre.

Les universités multilingues ont besoin d'une évaluation fiables des compétences en langues étrangères basées sur des normes comparables. Cette série d'ateliers s'adresse aux professeurs de langues et aux chercheurs et les dotera de compétences clés dans le domaine de la maîtrise de l'évaluation. Nous traiterons des critères de qualité dans le développement des tests, des procédures statistiques pour l'évaluation des tests et de la qualité des tâches, le lien fiable des tâches avec le Cadre européen commun de référence pour les langues et les défis que la numérisation (également) apporte à l'enseignement des langues : e-cheating .

Inscription

Veuillez vous inscrire au moins 6 jours avant la date de l'atelier respectif. Vous serez alors informé suffisamment à l'avance si nous pouvons confirmer une place.

Vous recevrez également toutes les informations complémentaires (lien zoom) par e-mail.

L'atelier est gratuit pour les membres du personnel des universités partenaires d'Arqus Alliance.

Programmation

- Qui s'est trompé ? Moi ou les étudiants ? – Analyser la qualité d'un test à l'aide de statistiques (très) simples.

Carolyn Westbrook (Conseil britannique).

Le 15 novembre 2021 de 16h00 à 19h15.

Lorsque nous concevons un test, nous pensons (espérons) que nous avons fait du bon travail. Nous voulons que le test fasse la distinction entre les apprenants à différents niveaux et qu'il reflète fidèlement les capacités réelles des apprenants. Mais comment savoir si nous y sommes parvenus ? Nous pouvons avoir une idée en notant le test, mais avec un grand nombre d'étudiants (en particulier si les tests sont notés de manière anonyme), nous ne pourrons peut-être pas dire si les bons étudiants réussissent bien et les étudiants plus faibles ont des difficultés. Alors comment le savoir ?

Cet atelier présentera quelques statistiques de base pour évaluer la qualité des tests. Pour les tests de compétences réceptives, nous examinerons ce que sont la facilité d'item et la discrimination d'item, comment les calculer et comment les interpréter. Nous discuterons ensuite de l'importance de la fiabilité de l'évaluateur pour les tests et évaluations de compétences productives, comment la calculer et comment l'interpréter. Idéalement, les participants devraient avoir accès à Excel pendant la session.

ENREGISTREMENT avant le 9 novembre 2021.

- Comment les échelles du CECR et les tâches de test peuvent-elles être liées les unes aux autres ?

Anja Peters & Claudia Pop (Institut TestDaF).

Le 18 novembre 2021, de 14h00 à 17h15.

Cet atelier fournira aux participants des conseils sur la façon de relier les tâches de test pour les compétences réceptives au CECR. Après une brève introduction à l'objectif, au contenu et à l'impact du CECR et de son Companion Volume, nous analyserons une sélection d'échelles et de descripteurs du Companion Volume afin de mieux comprendre les caractéristiques clés des niveaux, en particulier le « plus » niveaux. Ceci sera suivi d'une discussion sur des exemples de tâches en ce qui concerne leurs forces, leurs faiblesses et leur relation avec des niveaux spécifiques du CECR. Enfin, nous considérerons le processus d'écriture d'items, par exemple, comment augmenter ou diminuer la difficulté des tâches et des items de test.

ENREGISTREMENT, avant le 12 novembre 2021.

- De la triche à la triche électronique, de la triche électronique à… où ? Anna Soltyska (Université de la Ruhr Bochum).

Le 02 décembre 2021, de 16h00 à 19h30.

Le passage sans précédent des activités en face à face sur le campus à celles qui se déroulent en ligne a affecté presque tous les domaines de l'enseignement supérieur au cours de la récente pandémie de Covid-19, et l'enseignement, l'apprentissage et l'évaluation des langues étrangères ne font pas exception.

Naturellement, la mise en ligne des pratiques d'évaluation tout en préservant leur haute qualité s'est avérée difficile pour toutes les parties prenantes. Entre autres, des inquiétudes majeures ont été exprimées quant à la fiabilité des tâches d'évaluation nouvellement développées et souvent insuffisamment pilotées qui ne semblent pas infalsifiables et donc facilement manipulées ou mal utilisées.

L'atelier traitera du concept général de faute professionnelle liée à l'évaluation dans le contexte des tests de langue dans l'enseignement supérieur. Les participants auront l'opportunité de partager leurs expériences et celles de leurs institutions avec le phénomène de la (e-)triche et de travailler à des mesures réalisables pour le réduire dans leurs contextes, garantissant ainsi davantage de services d'évaluation de haute qualité. Cet objectif vise à renforcer l'alliance universitaire Arqus grâce à une collaboration plus étroite entre les experts en langues et les centres de langues et à renforcer la reconnaissance mutuelle des certificats de langue délivrés par les universités membres.

L'atelier sera offert via Zoom et durera 2x90 minutes. La première partie intitulée « De la triche à la triche électronique » sera consacrée à la transition progressive de l'analogique au numérique et aux contre-mesures pertinentes qui ont été proposées, sinon mises en œuvre, jusqu'à présent. Dans la partie suivante intitulée « De la triche électronique à… où ? les participants discuteront des développements actuels de la triche électronique et de leurs implications sur l'élaboration de procédures d'évaluation valides et fiables de demain.

ENREGISTREMENT, avant le 26 novembre 2021.

- Bonnes pratiques en matière de tests et d'évaluation linguistiques. Benjamin Kremmel (Université d'Innsbruck).

Le 15 décembre 2021, de 15h00 à 18h15.

Les tests de langue sont omniprésents dans les contextes éducatifs. Mais qu'est-ce qui distingue les tests de langues utiles de la multitude de tests qui génèrent peu d'informations précieuses pour les enseignants ou les apprenants en langues ? Comment mieux comprendre et évaluer les tests de langue ? Et que devons-nous rechercher lorsque nous voulons créer nous-mêmes des tests utiles ?

L'atelier abordera ces questions fondamentales et tentera d'illustrer d'importants principes de bonne pratique dans les tests de langue. Les différents objectifs des tests et leurs implications seront expliqués, et des directives pratiques pour créer des tests de langue utiles seront présentées à travers une introduction aux critères de qualité clés et aux outils et techniques pratiques pour le développement de tests tels que le développement de spécifications de test.

ENREGISTREMENT, avant le 9 décembre 2021.

Pour toute demande, merci de contacter Jupp Möhring

Afin d'assurer la qualité de la session et pour le bénéfice des participants, nous limitons le nombre de participants pour chaque atelier à un maximum de 21 personnes. Il y a trois places d'atelier par université partenaire et par atelier, et celles-ci seront attribuées selon le principe du premier arrivé, premier servi. S'il y a moins de trois inscriptions d'une université, les places restantes seront attribuées dans l'ordre de la liste quelle que soit l'affiliation à une université partenaire.

Pour plus d'information, rendez-vous directement sur le site internet Arqus.

Pour rester informé de l’actualité liée à Arqus, pensez à consulter régulièrement la page d’actualité de la Direction de l’International.